Катастрофоустойчивость корпоративного дата-центра как услуга

Содержание:

- ИТ-инфраструктура

- Что нельзя отдавать подрядчику

- 2017

- Центр мониторинга

- «Трэш-дата-центры»

- Воздушки, релейки, кабель в окно: как не напороться на провайдера-монополиста в бизнес-центре

- Как построить ракетный ускоритель для скриптов PowerCLI

- Теперь я знаю, что у коллеги есть питон, или Как наша команда поддерживает отношения на расстоянии во время удаленки

- 2018

- Сетевая инфраструктура

- Open source VS проприетарный подход

- История

- Аварийные выезды

- Между Москвой и Санкт-Петербургом: экскурсия по мегаЦОДу «Удомля»

- Инфраструктура

ИТ-инфраструктура

Современный центр обработки данных (ЦОД) включает серверный комплекс, систему хранения данных, систему эксплуатации и систему информационной безопасности, которые интегрированы между собой и объединены высокопроизводительной ЛВС (рис. 1).

Рис. 1. ИТ-инфраструктура современного ЦОД

Рассмотрим организацию серверного комплекса и системы хранения данных.

Серверный комплекс ЦОД

Наиболее перспективной моделью серверного комплекса является модель с многоуровневой архитектурой, в которой выделяется несколько групп серверов (см. рис. 1):

- ресурсные серверы, или серверы информационных ресурсов, отвечают за сохранение и предоставление данных серверам приложений; например, файл-серверы;

- серверы приложений выполняют обработку данных в соответствии с бизнес-логикой системы; например, серверы, выполняющие модули SAP R/3;

- серверы представления информации осуществляют интерфейс между пользователями и серверами приложений; например, web-серверы;

- служебные серверы обеспечивают работу других подсистем ЦОД; например, серверы управления системой резервного копирования.

К серверам разных групп предъявляются различные требования в зависимости от условий их эксплуатации. В частности, для серверов представления информации характерен большой поток коротких запросов от пользователей, поэтому они должны хорошо горизонтально масштабироваться (увеличение количества серверов) для обеспечения распределения нагрузки.

Для серверов приложений требование по горизонтальной масштабируемости остается, но оно не является критичным. Для них обязательна достаточная вертикальная масштабируемость (возможность наращивания количества процессоров, объемов оперативной памяти и каналов ввода-вывода) для обработки мультиплексированных запросов от пользователей и выполнения бизнес-логики решаемых задач.

Системы хранения данных

Наиболее перспективным решением организации системы хранения данных (СХД) является технология SAN (Storage Area Network), обеспечивающая отказоустойчивый доступ серверов к ресурсам хранения и позволяющая сократить совокупную стоимость владения ИТ-инфраструктурой за счет возможности оптимального онлайнового управления доступа серверов к ресурсам хранения.

СХД состоит из устройств хранения информации, серверов, системы управления и коммуникационной инфраструктуры, обеспечивающей физическую связь между элементами сети хранения данных (рис. 2).

Рис. 2. Система хранения данных на базе технологии SAN

Подобная архитектура позволяет обеспечить бесперебойное и безопасное хранение данных и обмен данными между элементами сети хранения данных.

В основе концепции SAN лежит возможность соединения любого из серверов с любым устройством хранения данных, работающим по протоколу Fibre Channel (FC). Техническую основу сети хранения данных составляют волоконно-оптические соединения, FC-HBA и FC-коммутаторы, в настоящее время обеспечивающие скорость передачи 200 Мбайт/с.

Применение SAN в качестве транспортной основы системы хранения данных дает возможность динамической реконфигурации (добавление новых устройств, изменение конфигураций имеющихся и их обслуживание) без остановки системы, а также обеспечивает быструю перегруппировку устройств в соответствии с изменившимися требованиями и рациональное использование производственных площадей.

Высокая скорость передачи данных по SAN (200 Мбайт/с) позволяет в реальном времени реплицировать изменяющиеся данные в резервный центр или в удаленное хранилище. Удобные средства администрирования SAN дают возможность сократить численность обслуживающего персонала, что снижает стоимость содержания подсистемы хранения данных.

Что нельзя отдавать подрядчику

Все, что записано в технической части, можно и иногда нужно отдать на аутсорс. В этом случае у вас остается только функция управления и контроля над подрядчиками. Кто это должен делать с вашей стороны, расскажу чуть ниже.

С организационной составляющей сложнее. Почти все из этого списка придется делать самостоятельно. Давайте разберемся, почему так.

Ведение документации. Регламенты и инструкции нужны для того, чтобы у всей команды по эксплуатации было одинаковое представление о процессах и алгоритмах действий (например, о том, как надо тестировать ДГУ). А еще для того, чтобы «священное знание» не пропало вместе с заболевшим или уволившимся инженером Васей. В теории написание документации тоже можно доверить подрядчику, — тем более не каждый инженер серверной сможет или захочет заниматься бумажками. Но правда в том, что лучше вас ваши процессы никто не знает, а отслеживать все изменения и поддерживать актуальность документации, не работая постоянно на объекте, вовсе из разряда «миссия невыполнима». Как вариант, совместно с подрядчиком можно разработать документацию, а следить за ее актуальностью уже самим на месте.

Сбор и анализ статистики. Ситуация примерно такая же, как и в предыдущем пункте, поэтому берем ручку/клавиатуру и методично записываем «историю болезни» каждого кондиционера, ДГУ и дальше по списку оборудования. Раз в квартал, полгода или хотя бы год заглядываем туда, чтобы понять, что и как часто у нас ломается. Информация пригодится при составлении бюджета на эксплуатацию, планировании ЗИП, а также поможет выявить, есть ли оборудование, которому уже не помогут ремонты, и его нужно полностью менять.

Список поломок и типов ремонта для одного из кондиционеров.

Контроль за установкой ИТ-оборудования и управление мощностью. Про это многие забывают, а зря. Айтишник увидел свободный юнит и воткнул оборудование, не посмотрев, хватает ли мощности в данной стойке, холода, и вообще правильно ли установил. А все претензии потом инженеру эксплуатации — за моргнувшее питание (из-за того, что сервер c одним блоком питания подключен без АВР или обоими блоками питания в одно PDU) или тормоза оборудования из-за локального перегрева.

Чтобы уменьшить количество проблем по этой части, делайте понятные инструкции, чек-листы для тех, кто занимается установкой оборудования, и периодически проверяйте, как установлено ИТ-оборудование (особенно внимательно если загрузка зала перевалила за 50%). Периодичность проверок будет зависеть от того, как часто в машинном зале появляется новое оборудование.

Алгоритм для отработки запроса на установку нового оборудования.

Планирование работ (ТО и наряды на работу). Совместно с подрядчиком согласовываем график работ, исходя из загрузки персонала (не должно быть работ по всем системам в одну неделю). Также выдаем наряды на работу и согласовываем с подрядчиком форму приема работ (акт, чек-лист и пр.).

Бюджетирование. Лучше делать самостоятельно. В зависимости от того, как заведено у вас — каждый месяц, квартал или сразу на год, операционное или инвестиционное. Про составление бюджета своими силами скоро напишу отдельно. Если отдать подрядчику, угадайте, что будет с бюджетом? Правильно, скорее всего, он вырастет. Произойдет это даже не из корыстного умысла подрядчика, а просто потому что он не будет так печься об экономии, как это делали бы вы.

Даже если как-то умудрились отдать подрядчику все описанное выше, то сидеть, закинув ноги на стол, и просто оплачивать счета не получится: подрядчиков нужно обучать и контролировать.

Учить подрядчиков, в первую очередь, нужно жизни правилам работы в дата-центре и серверной. Кроме, «не пить, не курить и не дебоширить», есть и технические нюансы. Например, от вас подрядчик должен узнать, что при ТО кондиционеров нельзя отключать больше одного за раз, а перед тем, как отключить, нужно проверить, что остальные кондиционеры работают исправно.

Контроль за доступом на объект тоже останется на ваших плечах. Проверять актуальность списков, график доступа на объект (круглосуточный или только в рабочие дни), наличие корочек по электробезопасности и прочих необходимых удостоверений — ваша и только ваша задача.

В общем помните, что за работоспособность серверной или дата-центра отвечаете в конечном итоге вы, а не подрядчик.

Выдержка из правил работы в наших дата-центрах для подрядчиков.

2017

Снижение показателя PUE до 1,29

Коммерческий дата-центр Санкт-Петербурга Xelent подвел итоги технического развития в 2017 году. За прошедший год среднегодовой показатель PUE (Power Usage Effectiveness) дата-центра составил 1,29. Это самые низкие показатели не только на петербургском рынке дата-центов, но и во всей России (среди публично доступных на 1 января 2018 года), утверждают в дата-центре. Добиться такого результата позволила оптимизация организации самого ЦОДа, а также собственная инновационная система охлаждения, в которой используется роторный теплообменник.

За три года Xelent сумел снизить среднегодовой показатель PUE с 1,45 в 2015 до 1,29 в 2017 — в российских дата-центрах, открывающих данные о показателе PUE, он составляет 1,3 и выше. Ключевым результатом улучшения показателя PUE стало снижение расходов на электроэнергию, которые в российских ЦОДах составляют от 25 до 50% операционных затрат. Таким образом, дата-центр получает возможность предоставлять клиентам услуги, более эффективные с точки зрения затрат на ИТ-инфраструктуру.

| Такая динамика снижения за три года — следствие постоянной работы по технической оптимизации ЦОДа, обеспечению бесперебойности его электро- и холодоснабжения, — пояснил Евгений Родин, директор по эксплуатации дата-центра Xelent. — Мы выстраиваем долгосрочную стратегию бизнеса исходя из того, что совершенствование технической базы, в том числе системы охлаждения, позволяет формировать оптимальные предложения для клиентов. На ближайшие 2018 и 2019 годы поставлена цель улучшать этот показатель на 0,01-0,02 в год за счет оптимизации распределения воздушных потоков и повышения качества изоляции холодных и горячих коридоров. |

Дата-центр Xelent обеспечит бесшовный переезд по России

Петербургский дата-центр Xelent представил в июле 2017 года услугу по перевозу оборудования из любого дата-центра или офиса в ЦОД Xelent с переносом ИТ-инфраструктур клиентов в облачную среду. Переезд происходит «бесшовно» – без остановки сервисов, с организацией резервной площадки и плана страхования. Услуга доступна клиентам из любой точки России.

Проект переезда включает в себя согласование плана миграции, места размещения и коммутации, перенос ИТ-инфраструктуры в облако, демонтаж оборудования, упаковку, перевозку, распаковку, монтаж оборудования, восстановление коммутации и проверку работоспособности совместно с клиентом. Ранее дата-центр Xelent предоставлял услуги по переезду оборудования без переноса ИТ-инфраструктур в облако.

Переименование в Xelent

В марте дата-центр SDN (Stack Data Network) провел ребрендинг и изменил название. Топ-менеджеры компании анонсировали новый бренд Xelent и маркетинговую стратегию.

Эффективность обслуживания инфраструктуры позволяют Xelent экономить на поддержке работы оборудования и делать клиентам более выгодные ценовые предложения. Компания наращивает мощности с минимальными затратами: ЦОД рассчитан на 1476 стоек, и из них уже 1074 (6 серверных модулей по 164 ячейки в каждом) введены в эксплуатацию. Еще три модуля будут запущены в ближайшее время.

Надежность оборудования, ценовое лидерство и развитая система продаж положительно сказались на приросте числа клиентов: 308 компаний разместили свое оборудование или арендовали мощности ЦОДа Xelent (550 оплачиваемых стоек). Более 300 клиентовдата-центра – региональные и федеральные предприятия разных масштабов и отраслевых рынков: торговля, логистика, туризм, финансы и др.

Эксперты Xelent отметили, что даже в такой ситуации наибольший доход компания получает не от регионального предпринимательского сектора, а от крупных игроков цифрового рынка – контент- и ИТ-провайдеров. На их долю (чуть более 5% от общего числа клиентов) приходится до 58% выручки. По его мнению, региональный бизнес пока только приходит к пониманию, что с цифровизацией бизнес-процессов доход компании любого масштаба зависит от качества и уровня надежности ее ИТ-инфрастуктуры. При этом предложений на рынке с каждым днем все больше.

KPI

Доля облачных услуг дата-центра не превышает 5% от общего числа, но уже к 2020 году Xelent планирует увеличить ее до 40%. Среди других ЦОД будет предлагать услуги SaaS (VDI– виртуальные рабочие столы) и IaaS (`vDC` – виртуальный дата-центр; `VPS\VDS` – виртуальный сервер и `cloud storage` – облачное хранилище).

Центр мониторинга

Сетевой операционный центр (NOC). В нем работают эксперты по поддержке ЦОД.

- Эксперты NOC, диагностирующие инциденты в ЦОД, должны иметь подготовку в области информационной безопасности и обширный опыт. Анализ и документирование инцидентов снижает вероятность ошибок в будущем.

- Любая система цифрового дистанционного мониторинга должна предусматривать документирование всех инцидентов.

- Сервис должен сокращать время устранения проблемы с помощью тревожных сообщений (alarm), удаленного устранения неполадок и прозрачности жизненного цикла устройства. Руководить устранением неполадок должны эксперты, которые мониторят центр данных в режиме 7 x 24.

- Эти же эксперты должны иметь список контактов на случай критичных событий. Хорошо, если данный список постоянно актуализируется в мобильном приложении.

- Знание состояния всех устройств повышает шансы быстро устранить проблему или хотя бы понять ее причину.

- Чтобы обслуживающему персоналу реже приходилось копаться с оборудованием, полезно использовать предиктивную аналитику и удаленную диагностику.

Сервисный инженер должен знать, что именно ему потребуется заменить или исправить, чтобы не выезжать на объект повторно.

«Трэш-дата-центры»

В последние годы на фоне глобального кризиса получили развитие проекты максимально бюджетных «трэш-дата-центров» (англ. trash — мусор). Как правило, это большой склад либо ангар, минимально приспособленный для размещения стоек, который по классификации TIA-942 не всегда соответствует даже уровню Tier I. Клиент обеспечивается негарантированным электропитанием, подключением к Интернету и местом для стойки. Если клиент желает иметь гарантированное электропитание, то должен поставить собственный ИБП в стойку. Охлаждение оборудования происходит за счёт естественного воздухообмена в помещении.

Достоинством данной услуги для клиента является крайне низкая цена, составляющая до 20—30 % от стоимости размещения сервера в дата-центрах уровня Tier II и Tier III. Однако стоит отметить, что отсутствие централизованных систем бесперебойного питания, кондиционирования и пожаротушения позволяет использовать данные ЦОДы лишь как временное решение и крайнюю меру.

Воздушки, релейки, кабель в окно: как не напороться на провайдера-монополиста в бизнес-центре

Вот как выкручиваются клиенты, попавшие на провайдера-монополиста. Оптика на фонарных столбах — это и есть «воздушка».

Один наш клиент искал офис в аренду в Москве. Нашел подходящий в крупном бизнес-центре: в центре, с парковкой и по привлекательной цене. Компания заключила договор на 3 года, влила несколько миллионов в отделку, закупила красивые столы и аккуратно вывела розетки.

Но грабли постучались в дверь, когда ИТ-служба подключала интернет. Бизнес-центр предложил арендатору на выбор двух провайдеров: плохого и очень плохого. Оба работали в здании на эксклюзивных правах и предлагали интернет за 25% от стоимости занятой площади. И это не предел. Стоимость интернета может доходить до 50% от площади. Так арендодатель компенсирует дешевые квадратные метры.

Что в итоге получает арендатор: договор подписан на год или даже на три, интернет дорогой, но некачественный, и — вишенка на торте — организовать резервный канал нельзя.

Проблема в том, что такое бывает даже в бизнес-центрах класса А. Попадаются, в том числе, крупные компании со штатом юристов. Расскажем, как не оказаться в такой ситуации и что можно сделать, если самое страшное уже случилось.

Как построить ракетный ускоритель для скриптов PowerCLI

Рано или поздно любой системный администратор VMware доходит до автоматизации рутинных задач. Начинается все с командной строки, потом идет PowerShell или VMware PowerCLI.

Допустим, вы освоили PowerShell чуть дальше запуска ISE и использования стандартных командлетов из модулей, которые работают за счет «какой-то магии». Когда вы начнете считать виртуальные машины сотнями, то обнаружите, что скрипты, которые выручали на малых масштабах, работают заметно медленнее на больших.

В этой ситуации выручат 2 инструмента:

- PowerShell Runspaces – подход, который позволяет распараллелить выполнение процессов в отдельных потоках;

- Get-View – базовая функция PowerCLI, аналог Get-WMIObject в Windows. Этот командлет не тянет за собой сопутствующие сущности объекты, а получает информацию в виде простого объекта с простыми типами данных. Во многих случаях выходит быстрее.

Дальше кратко расскажу про каждый инструмент и покажу примеры использования. Разберем конкретные скрипты и посмотрим, когда лучше работает один, когда второй. Поехали!

Теперь я знаю, что у коллеги есть питон, или Как наша команда поддерживает отношения на расстоянии во время удаленки

Привет, Хабр! Меня зовут Даша Рудник, я руковожу HR в DataLine. В нашей компании работает почти 500 человек, и до эпидемии коронавируса мы уже многое знали про распределенную работу. Часть сотрудников сидела в офисе на Боровой, часть – на Коровинском шоссе, был свой десант в Санкт-Петербурге. В марте мы перешли на удаленку за 1 день, и все завертелось: конф-коллы, видеоконференции, рабочие чаты.

Поток информации рос, рабочие процессы быстро перестраивались, но нам хотелось сохранить и нашу неформальную атмосферу. Замену стандартным совещаниям мы нашли, а как быть со смолтоками у кулера и в курилке? Что делать, если больше нельзя обменяться новостями в очереди за кофе и поджемить в музыкальной комнате после обеда? Мы боялись, что без привычных ритуалов и общения начнем грустить.В очереди за кофе мы заряжались настроением, болтали с баристой и узнавали новости.

Почти сразу эйчары и руководители стали придумывать новые форматы для неформального общения, а сотрудники предлагали свои идеи. И вот что теперь помогает нам поддерживать друг друга на удаленке.

2018

Уровень заполнения ЦОД достиг 75%

4 февраля 2019 года стало известно, что Дата-центр Xelent подвел итоги первых пяти лет работы. К 2018 году уровень заполнения ЦОД достиг 75%, а доля Xelent на петербургском рынке дата-центров за прошедшие годы превысила 25%. На февраль 2019 года компания является участником национальной инфраструктуры цифровой экономики в части хранения данных.

Дата-центр Xelent, спроектированный с учетом требований стандарта Tier III, рассчитан на размещение более 70 тыс. единиц оборудования. За 5 лет компания «СДН», оператор ЦОД, построила 5 дополнительных серверных модулей и увеличила количество стоек для заказчиков в 7 раз. Мощности дата-центра обеспечивают бесперебойную работу ИТ-инфраструктур сотен крупных российских компаний из разных отраслей: финансовой сферы, оптовой и розничной торговли, транспорта и логистики, госсектора и многих других.

Одним из ключевых событий за 5 лет работы стало формирование облачного направления, в том числе запуск облачной платформы Xelent.cloud

Важной вехой стал старт работы агрегатора облачных услуг Xelent.MultiCloud, в рамках которого компания разрабатывает и реализует комплексные проекты IT-инфраструктуры с применением сервисов провайдеров на базе 4 гипервизоров. Продажи облачных продуктов по итогам двух лет выросли более, чем в 9 раз.

|

Среди наших заказчиков становится все больше технологичных компаний — это сервисные и облачные провайдеры, социальные сети, разработчики приложений. Особое место занимают финансовые организации: увеличение их количества привело нас к сертификации по стандарту PCI DSS и внедрению его норм в ежедневных обиход. Для `профессиональных` заказчиков мы разработали такие услуги, как «ЦОД в ЦОДе», предоставили им дополнительную физическую и интеллектуальную защиту. Илья Рогов, директор по маркетингу Xelent |

За 5 лет Xelent добился существенных технологических успехов. Команде дата-центра удалось добиться низкого показателя энергоэффективности (PUE) — на февраль 2019 года он находится на уровне 1,3. Для сравнения, по итогам 2018 года средний показатель PUE в мире составил 1,58.

|

На стадии проектирования дата-центра мы ориентировались на заказчиков из Европы и США. Однако старт коммерческой эксплуатации пришелся на начало 2014 года, который принес значительные политические и экономические перемены. В условиях санкций западные компании начали пересматривать свои планы по развитию бизнеса в России: переговоры были заморожены и основными клиентами для нас стали российские компании. Андрей Елисеев, директор петербургского филиала Xelent |

Среднегодовой показатель энергоэффективности ЦОД — 1,3

28 января 2019 года компания Xelent сообщила, что подвела технические итоги 2018 года. Среднегодовой показатель энергоэффективности ЦОД (PUE) составил 1,3. Это на одну сотую выше 2017 года. Причина роста показателя на 0,01 — аномально жаркое лето на европейской территории России, одно из самых теплых за всю историю наблюдений, что стало испытанием для систем охлаждения всех дата-центров.

По информации компании, на протяжении трех лет дата-центру Xelent удавалось повышать уровень энергоэффективности: среднегодовой показатель PUE в период с 2015 по 2017 год включительно уменьшился с 1,45 до 1,29. Лучшие значения PUE за 2018 год удалось получить в январе, феврале, ноябре и декабре: показатель составил 1,24, что в среднем на две сотых лучше, чем годом ранее. Сложнее всего было обеспечить уровень энергоэффективности в аномально жаркий для петербургского климата период с мая по сентябрь, когда среднемесячные температуры, по данным системы мониторинга погодных показателей Xelent, были на 2 — 4 °С выше, чем в 2017 году.

|

В 2018 году мы планировали сократить среднегодовой PUE еще на 0,01 — 0,02 за счет оптимизации распределения воздушных потоков и улучшения качества изоляции холодных и горячих коридоров. Но аномально жаркое лето – серьезный вызов для системы охлаждения. В таких условиях PUE 1,3 – это хороший показатель. Благодаря нашей системе охлаждения Киото-кулинг дата-центр не только экономит электроэнергию, но и обеспечивает уровень надежности всех систем. Среднегодовые PUE Xelent подтверждают правильность выбора региона для размещения дата-центра. Северо-Запад России оптимален как с точки зрения большого количества квалифицированных кадров, обеспечения хорошей связности, так и с точки зрения климатических условий и энергоэффективности Евгений Родин, директор по эксплуатации дата-центра Xelent |

Сетевая инфраструктура

Коммуникации дата-центра чаще всего базируются на сетях с использованием протокола IP. Дата-центр содержит несколько роутеров и свитчей, которые управляют трафиком между серверами и «внешним миром». Для надёжности дата-центр иногда подключен к интернету с помощью множества разных внешних каналов от разных провайдеров.

Некоторые серверы в дата-центре служат для работы базовых интернет- и интранет-служб, которые используются внутри организации: почтовые сервера, прокси-сервера, DNS-сервера и т. п.

Сетевой уровень безопасности поддерживают межсетевые экраны, VPN-шлюзы, IDS-системы и т. д. Также используются системы мониторинга трафика и некоторых приложений.

Open source VS проприетарный подход

- Проприетарный. То есть предположим, что уже сделаны существенные вложения в платформу на VMware. И вы продолжаете развивать облако используя то, что предлагает или рекомендует вендор.

- Гибридный. Вы можете зафиксировать текущую инфраструктуру. И поверх нее создать облачное решение на базе Openstack. Чаще всего, такой путь начинается с того, что у вас уже есть хороший виртуализатор (как правило, это VMware или KVM), вокруг которого выстраивается стек открытого ПО. Как правило, крупные игроки идут к этому.

Все понимают, что VMware сейчас под своим зонтиком собрал огромное количество технологий и уверенно продолжает их разработку. Но и открытые решения не отстают, как показывает практика. Чего стоит только то, что и сам VMware выпустил и ведет разработку собственной версии Openstack, которая имеет набор функциональных возможностей по работе именно в среде VMware. Как раз как система управления облаком.

То есть второй путь фактически легализован.

При этом использование именно вмварной версии не требуется. Особенно если вы в дальнейшем планируете отказаться от VMware в целом, существенно сокращая затраты.

Тем не менее, далее пара-тройка фич, которые могут сыграть роль при выборе.

История

История развития дата-центров начинается с огромных компьютерных комнат времен зарождения компьютерной индустрии. Тогда компьютерные системы были сложнее в управлении и требовали обеспечения особых условий для работы. Так как они занимали много места и требовали множества проводов для подключения различных компонентов, в компьютерных комнатах стали применять стандартные серверные стойки, фальшполы и кабельные каналы (проложенные по потолку или под фальшполом). Кроме того, такие системы потребляли много энергии и нуждались в постоянном охлаждении, чтобы оборудование не перегревалось. Не менее важна была безопасность — оборудование весьма дорогостоящее и часто использовалось для военных нужд. Поэтому были разработаны основные конструкционные принципы по контролю доступа в серверные.

В период бурного развития компьютерной индустрии и особенно в 1980-е компьютеры начинают использовать повсеместно, не особенно заботясь об эксплуатационных требованиях. Но с развитием ИТ-отрасли компании начинают уделять все больше внимания контролю ИТ-ресурсов. С изобретением архитектуры клиент-сервер в 1990-е микрокомпьютеры, сейчас называемые серверами, стали занимать места в старых серверных. Доступность недорогого сетевого оборудования вместе с новыми стандартами сетевых кабелей сделали возможным использование иерархического проектирования, так серверы переехали в отдельные комнаты. Термин «дата-центр», в те времена применимый к специально спроектированным серверным, начал набирать популярность и становился все более узнаваем.

Бум дата-центров приходится на период 1995—2000 годов. Компаниям было необходимо устойчивое и высокоскоростное соединение с Интернетом и бесперебойная работа оборудования, чтобы разворачивать системы и устанавливать своё присутствие в сети. Разместить оборудование, способное справиться с решением этих задач, было делом непосильным для большинства небольших компаний. Тогда и началось строительство отдельных больших помещений, способных обеспечить бизнес всем необходимым набором решений для размещения компьютерных систем и их эксплуатации. Стали развиваться новые технологии для решения вопросов масштаба и операционных требований столь крупных систем.

В наши дни проектирование и строительство дата-центров — хорошо изученная область. Сформированы стандарты, устанавливающие требования для проектирования дата-центров. К примеру специалисты Telecommunications Industry Association внесли большой вклад в формирование стандартов для дата-центров. Но все же осталось ещё много нерешенных задач в методах работы, а также строительстве дата-центров, не наносящих вреда окружающей среде и т. д.

Дата-центры требуют больших затрат как на этапе строительства, так и в процессе обслуживания, для поддержания работы на должном уровне. К примеру, дата-центр Amazon.com в Орегоне, площадь которого равна 10 800 м², оценивается в 100 млн $.

Аварийные выезды

Аварийный выезд требуется в тех случаях, когда поломка оборудования грозит остановкой сервиса и чинить нужно срочно. Например, если поломка кондиционера приводит росту температуры в машинном зале, то это как раз повод для аварийного выезда.

В отличие от штатных ремонтных работ, аварийный выезд можно организовать в любое время суток, в выходные и праздники. В Соглашении об уровне обслуживания (SLA), о котором мы тоже поговорим сегодня, обязательно прописывается время реагирования на заявку и приезда на площадку.

Сложно полностью прописать все случаи аварийных выездов, лучше закрепить за собой право определять их необходимость в договоре. Так у подрядчика не возникнет соблазна дискутировать о том, считать ли ту или иную поломку достойной аварийного выезда в 3 часа ночи в субботу. В качестве противовеса такой свободе подрядчик обычно прописывает стоимость аварийного вызова или ограничивает их количество в месяц. Это нормальная практика – подрядчику нужна какая-то защита от ложных тревог.

Стоимость аварийного выезда – плата за оперативный приезд специалистов в любое время суток. Сами работы обычно оплачиваются отдельно по человеко-часам или по прайсу, приложенному к договору. Эти траты тоже нужно учесть в бюджете.

Между Москвой и Санкт-Петербургом: экскурсия по мегаЦОДу «Удомля»

Где-то посередине между Москвой и Санкт-Петербургом есть небольшой город Удомля. Раньше он был известен Калининской АЭС. В 2019 году рядом появилась еще одна достопримечательность – мегаЦОД «Удомля» на 4 тыс. стоек.

После присоединения к команде Ростелеком-ЦОД специалисты DataLine также будут заниматься эксплуатацией этого дата-центра. Наверняка вы уже что-то слышали про «Удомлю». Сегодня мы решили подробно рассказать, как там все устроено.Индустриальные пейзажи: дата-центр площадью 32 000 м² и АЭС на заднем плане. Удомля образца весны 2019.

Под катом собрали больше 40 фото инженерных систем дата-центра с подробным описанием. Тех, кто дойдет до конца, ждет приятный сюрприз.

Инфраструктура

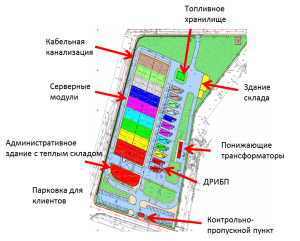

В основе стратегии регионального развития SDN лежат потенциал и возможности решения Stack.Куб, запатентованного в 2012 г. Модульные дата-центры, построенные по данной технологии, способны обеспечить ведущие по отрасли показатели надежности, энергоэффективности, экологичности, а также наилучшие в своём сегменте эксплуатационные характеристики.

Проектная емкость запускаемого ЦОД составляет 1476 стоек, которые размещаются в 9 серверных модулях. Площадка на любом этапе жизненного цикла может быть адаптирована к более высоким нагрузкам на стойку — принцип функционирования модульных дата-центров SDN позволяет без перерыва в предоставлении сервисов реализовать мягкий переход на использование энергоёмких ИКТ-решений (вплоть до 40÷50 кВт на стойку), а также увеличивать количество модулей.

Среди основных особенностей узлов SDN в компании отметили: энергоэффективность (среднегодовое значение PUE не более 1,15), которая достигается за счёт гибкого управления воздушными потоками; высокую защиту от ошибок персонала — результат использования в дата-центре интегрированных систем мониторинга и интеллектуальных систем принятия решений, которые обеспечивают простоту и высокое качество прогнозирования событий; соответствие жёстким требованиям физической и информационной безопасности, что реализуется за счёт физического разделения всех функциональных модулей (серверных помещений и элементов системы жизнеобеспечения ДЦ), а также применения безопасных для оборудования и персонала технологий пожаротушения.

Все элементы конструктива и инженерной инфраструктуры модульных дата-центров SDN изготавливаются и проходят контроль качества на профильных заводах Европы и России, что обеспечивает их стандартизацию и упрощает обслуживание и проведение регламентных работ.

Сбалансированные эксплуатационные характеристики, заложенные в принцип функционирования модульных дата-центров SDN, позволяют обеспечить на новых площадках возможность выбора уровня надёжности стоек клиента в диапазоне от Tier II до Tier IV по классификации Uptime Institute — в зависимости от бизнес-задач корпоративных клиентов и специфики ИКТ-оборудования.

Кроме того, в отличие от большинства проектов, выполненных в России за последние годы, дата-центры в Санкт-Петербурге и Казани не встраиваются в уже готовое помещение, а создаются с нуля — на специально выделенном участке земли, подчеркнули в компании. Каждый из них будет представлять собой отдельно стоящее здание с реализованной под ключ инженерной инфраструктурой с высоким уровнем резервирования компонентов. Благодаря модульному принципу организации дата-центров темпы ввода их в эксплуатацию и модернизации существенно выше при масштабах и характеристиках, сравнимых с классическими решениями, утверждают в SDN.

Все здания и сооружения комплекса возведены по специальному проекту на собственном земельном участке площадью более 3 га, обеспеченном технологическим подключением к сетям Ленэнерго мощностью 14 МВт. Помимо технологических модулей комплекс включает офисные помещения для размещения клиентов и обслуживающего персонала, складские помещения, резервное топливохранилище, погрузочно-разгрузочные и парковочные зоны.

Безопасность обеспечивается эшелонированной многоуровневой системой с применением современных технических средств. Уровень надёжности технологических систем обеспечен полным резервированием инженерной инфраструктуры, двумя независимыми внешними энергетическими вводами 10 кВ и двумя независимыми трассами ВОЛС, а также высококвалифицированной командой специалистов SDN в режиме эксплуатации 24x7x365.