Почему стоит перенести оборудование в дата-центр

Содержание:

- Итак, что делать, чтобы стойки не падали

- Сертификаты дата-центра, которые реально гарантируют качество

- «Главный инженер» — ответственный за все

- Варианты размещения в ЦОД

- Аренда сервера или покупка собственного?

- Проблемы ценообразования розничных услуг на рынке дата-центров

- Из чего в целом складывается эксплуатация дата-центра/серверной

- Закрытые стойки 47 юнитов или больше

- Администрирование и апгрейды арендованных серверов

- Наши принципы ценообразования

- Технические причины

- Как выбрать дата-центр для размещения или аренды сервера

- В Европе

- Безопасность

- Что нельзя отдавать подрядчику

- SLA, NDA, Uptime

- Что такое ЦОД

- Выводы

Итак, что делать, чтобы стойки не падали

-

По возможности, не экономить на закупке оборудования и его модернизации.

-

Не забывать про запасные блоки питания.

-

Не перегружать оборудование выше номинальной мощности. При расчете нагрузки всегда учитывать аварийный режим и проверять, что при падении одного луча на втором не будет перегруза.

-

Читать инструкции к оборудованию.

-

Не использовать «тонкие» и дешевые кабели питания и внимательно проверять контакты при подключении.

-

Не забывать про маркировку узлов подключения и следовать единой цветовой схеме для разных лучей питания.

-

Следить за единой цветовой схемой для проводников в щитах и на соединительных разъемах.

-

Следить за защитой от статического электричества: использовать специальные антистатические покрытия и снимать с себя статику перед работой в стойке.

-

Не проводить важные работы в стойке по устной договоренности, зафиксировать задачу письменно.

-

По возможности, не планировать важные работы в стойке на ночное время.

-

Проводить важные работы в стойке вдвоем.

-

Проверять подключение стойки под нагрузкой, перед тем как вводить ее в эксплуатацию. Можно привлечь к тесту специалистов вашего дата-центра: в согласованный период инженеры поочередно отключат автоматы и проверят корректность работы стойки. Так можно быть уверенными, что оборудование подключено правильно, нагрузки распределены верно и при сбое на одном луче стойка не обесточится.

-

Вести статистику случаев падения и выделять наиболее типичные ошибки. Фиксировать эти ошибки в инструкциях, регулярно их пересматривать и проводить учения на отработку навыков обращения со стойкой и щитами.

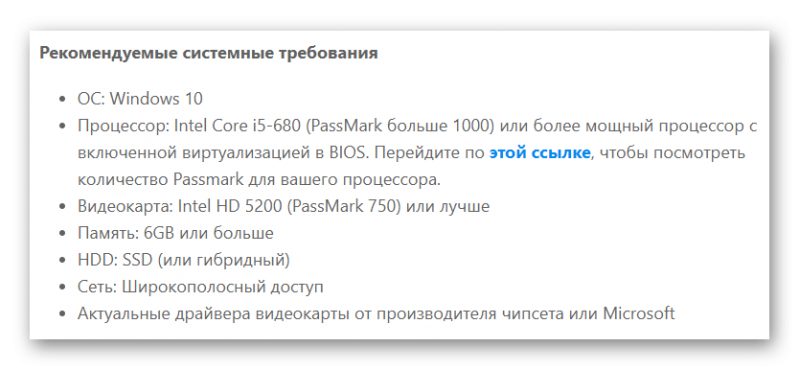

Сертификаты дата-центра, которые реально гарантируют качество

Если у дата-центра есть все три сертификата Tier III, то вы можете быть уверены, что там всё на высшем уровне — круче в России и в Москве не бывает. Вам гарантирован максимальный UPTIME. В ЦОД такого класса допускает простой не более 1.6 часа в год. Как правило в реальности там UPTIME 100% за несколько лет. Основные параметры стандарта Tier III можно посмотреть в сравнительной таблице Tier II и Tier III.

При этом обратите внимание — должны быть все три сертификата, причём сертификат Tier III Operations имеет срок годности, обязательно обращайте внимание, что он не просрочен. Если он просрочен, то дата-центр возможно не прошёл переаттестацию

У некоторых дата-центров есть только один сертификат на соответствие проекта. Такой сертификат говорит о том, что проект соответствует, а соответствует ли сам дата-центр неизвестно.

Вам могут потребоваться какие-то ещё сертификаты, но как правило, они тоже есть у таких дата-центров.Наличие сертификатов нужно проверять на сайте Uptime Institute. Сейчас многие пишут: “Tier 3”, а на деле сертификатов нет.

Если сертификатов нет и вы ищете поставщика услуг в эконом-классе, то читайте дальше, так как теперь при выборе вам придётся самим сравнивать предложения разных поставщиков.

«Главный инженер» — ответственный за все

Количество людей в вашей службе эксплуатации будет зависеть от заявленного SLA, объема инфраструктуры и того, как много вы планируете делать собственными силами. Универсальной формулу не подскажу, но вот на что можно опереться.

В каком режиме предоставляем услуги? Если 24х7, нужна круглосуточная служба поддержки как минимум из четырех человек, которые будут работать в четыре смены — сутки через трое. Если 8×5, то людей понадобится вдвое меньше.

Сколько нужно инженеров? Здесь многое будет зависеть от функций. Если нужно просто следить за мониторингом, то хватит и одного, если нужно делать обходы — минимум два человека. Если придется что-то делать руками (тянуть кроссировки, монтировать оборудование, менять фильтры в кондиционерах), то понадобится уже трое.

Храните ли ЗИП и расходники у себя? Если храните почти все, то понадобится кладовщик или закупщик, который будет следить за остатками и заказывать новые.

Название должностей и количество людей будет для каждого случая свое, но одна функция обязательно должна присутствовать при любом раскладе. Это функция «быть ответственным». Условно я называю эту позицию «главный инженер». В нашей иерархии это руководитель службы эксплуатации. Главная его функция — принимать решения, которые не обсуждаются: нужно ли вызывать подрядчика по аварийному вызову, можно ли отложить ремонт резервного кондиционера. Он же дает команду на отключение оборудования на время ТО, согласовывает срочные ремонтные работы, внеплановые закупки, руководит операцией по спасению дата-центра в случае аварий. К нему можно обратиться как в третейский суд, если инженер эксплуатации или подрядчик вдруг не может договориться с энергетиком о тестовых запусках ДГУ.

В целом, «главный инженер» в конечном итоге отвечает за всю эксплуатацию и инженерную инфраструктуру перед бизнесом или клиентам.

Подведем итоги. Программа «минимум» для службы эксплуатации дата-центра или серверной выглядит следующим образом:

- контроль и обучение подрядчиков;

- регулирование доступа на объект;

- назначение нарядов на работу;

- согласование графиков ТО;

- ведение документации и учета;

- анализ и сбор статистики;

- составление бюджета.

Если у вас есть вопросы, пишите в личку или приходите на мой ближайший семинар 4 июля, сможете обо всем спросить лично.

Другие статьи по управлению инженерной инфраструктурой дата-центра и серверной:

→ Путь электричества в дата-центре → Ошибки в проекте дата-центра, которые вы ощутите только на этапе эксплуатации → О животрепещущем в эксплуатации дата-центра → Как тестируют ДГУ в дата-центре → Мониторинг инженерной инфраструктуры в дата-центре. Часть 1. Основные моменты → Мониторинг инженерной инфраструктуры в дата-центре. Часть 2. Система энергоснабжения → Обслуживание инженерных систем ЦОД: что должно быть в договоре подряда → Dumb ways to die, или отчего “падают” дата-центры

Варианты размещения в ЦОД

Наша компания Xelent предлагает клиентам следующие услуги по переносу оборудования:

- Аренда серверной стойки. Вы можете зарезервировать стойку в нашем дата-центре, расчет стоимости будет произведен в зависимости от количества занимаемых юнитов. Такое решение потребует минимальных затрат с вашей стороны. Мы обеспечим несколько уровней защиты информации и создание резервных копий. Также в рамках услуги будет осуществлен перенос виртуальных машин из старого дата-центра. При этом исключается простой оборудования, так как миграция данных происходит бесшовно.

- Бесшовная миграция ИТ-инфраструктуры. Такая услуга предполагает демонтаж и монтаж серверов, копирование схемы коммутации, а также настройку, тестирование и проверку машин в нашем дата-центре. Возможен прием и хранение оборудования как на время пандемии коронавируса, так и на постоянной основе. В условиях карантина на услугу действует специальная цена –10 000 руб. за выезд по Санкт-Петербургу + 500 руб. за каждое устройство.

Подробнее о ЦОД вы можете узнать у наших менеджеров. Задавайте свои вопросы через форму на сайте или звоните по указанным номерам. Надеемся, что вы примете правильное решение и откажетесь от содержания серверов в своем офисе.

Популярные услуги

Аренда сервера или покупка собственного?

У современных компаний есть три варианта получения технологических ресурсов: аренда облачных решений, аренда серверов и собственное владение ими. Облачный сценарий, как повелось, в приоритете у предприятий, которым периодически нужно увеличивать пиковые нагрузки.

| К очевидным минусам такого подхода можно отнести возможность неконтролируемого доступа третьих лиц к размещенной в облаке информации, — считает генеральный директор ГК «Филанко» (сеть дата-центров DataHouse.ru) Дмитрий Шаров. — Присутствует и существенная вероятность отказа программного обеспечения при внесении каких-либо изменений. Мне известны как минимум два важных кейса, в которых крупная медицинская компания потеряла свои данные из-за сбоев в программном обеспечении облачного провайдера. |

Вопрос безопасности менее актуален для двух других сценариев: в них отсутствует возможность прямого доступа третьих лиц к данным компании. Споры о том, какой из вариантов надежнее, ведутся в ИТ-среде достаточно давно. Специалисты, в массе своей, сходятся на том, что вариант с собственным владением серверами подойдет предприятиям, которые обладают внушительным ИТ-бюджетом и собственным квалифицированным персоналом, тонко разбирающимся в аппаратных решениях. Аренда оборудования отличается тем, что в случае отказа каких-либо физических устройств, починка или замена будет произведена в точно оговоренные сроки. Этот сценарий также удобен компаниям, у которых не возникает внезапной потребности в дополнительной мощности.

| В случае аренды серверов затраты на размещение оборудования скрыты в общей стоимости, а если компания закупит собственное железо, то единственные типы расходов — это оплата электроэнергии и счетов за интернет, — уточняет Дмитрий Шаров. — С моей точки зрения, аренда оборудования — отличный способ фиксирования рисков, когда ваш проект уже не стартап, но еще не требует вычислительных мощностей размером в несколько стоек. |

Другой критерий востребованности варианта с арендой — если в ИТ-бюджете предусмотрены средства на OPEX-затраты, но ничего нет под CAPEX. При этом, как отмечают аналитики, этим путем идут компании со специфическими требованиями, например, к объемам дискового пространства.

Проблемы ценообразования розничных услуг на рынке дата-центров

Начнём с того, что нам самим не нравилось в ценообразовании у нас и у конкурентов:

-

Нелинейность цены за мощность.

-

Нелинейность цены за форм-фактор сервера.

-

Непрозрачность цен и скрытые цены.

В нулевые цены было непринято публиковать. Мы были первыми, кто выкладывал детальные прайс-лист на наши услуги. Уже наступили двадцатые, а на рынке есть дата-центры, где цен либо нет, либо только часть цен (потом оказывается за что-то нужно ещё доплатить), либо написано “Звоните”.

Ценообразование на рынке ЦОДов сложилось таким образом, что в одном дата-центре два сервера по одному юниту стоят дороже, чем один сервер в два юнита при том, что суммарная мощность основных блоков питания у них одинаковая. Так получается из-за разницы цены на первый юнит и на дополнительный юнит в сервере. По сути пользователи одноюнитовых серверов переплачивали, а двухюнитовых недоплачивали. Клиентам выгоднее поставить многоюнитовые сервера, чем одноюнитовые. А дата-центру, возможно, что и наоборот, так как многоюнитовый может быть набит плотнее комплектующими и потреблять больше нескольких одноюнитовых

И тут важно не поднять цены за многоюнитовые серверы, а снизить за одноюнитовые, чтобы в пересчёте за юнит и мощность все платили одинаково

Также проблемой является включенная мощность. Если в оборудовании блоки питания малой мощности до 300Вт, то по сути владелец такого оборудования переплачивает, так как обычно включено 300-400Вт мощности.

В последние годы стабильно растёт загрузка оборудования и потребляемая мощность на единицу оборудования и, соответственно, на стойку. В нулевых годах многие сервера по сути простаивали и были слабо загружены. Тогда телекоммуникационная стойка в 42 юнита могла потреблять и меньше 4кВт. Сейчас же стойки немного подросли, стали 47U и потребление составляет 6кВт и более.

В нулевых за мощность блоков питания деньги не брали. Стоимость colocation определялась исключительно формой корпуса и платой за трафик. Потом в первой половине десятых годов все перешли на безлимитные каналы 100Мбит/с. Но встал вопрос за что же брать деньги и начали брать за мощность блоков питания. Хотя тогда это ещё не было так оправдано, но рынок формировал тарифы в этом направлении. У нас за размещение в дата-центре Nord-4 платы за мощность не было до ноября 2020 года. Много лет мы выделялись тем, что не брали деньги за мощность. Клиентам это нравилось, так как многие клиенты отчасти справедливо говорили, что хоть в сервере и стоит блок питания 1000Вт, но сервер не является грелкой и киловатт тепла как радиатор не выдаёт.

Лет десять назад было ещё принято брать деньги за вторую резервную розетку для сервера, за второй Ethernet-порт, за салазки, KVM и каждый чих. В некоторых дата-центрах до сих пор, кстати, берут. Мы тоже когда-то брали. Но когда мы начали продавать услуги в двух дата-центрах премиальном и обычном, то самим стало стыдно, что цена в обычном дата-центре с накрутками могла стать дороже, чем в премиальном по программе всё включено. Поэтому мы отменили плату за мелочи.

Клиентов всегда раздражают ловушки когда на сайте и в рекламе одна цена, а потом оказывается, что в сервере два процессора, поэтому нужно ещё доплатить. Ведь с такой логикой можно всегда придумать за что ещё взять деньги.

Из чего в целом складывается эксплуатация дата-центра/серверной

Прежде, чем пойдем делить эксплуатацию между собственной командой и подрядчиком, вспомним, что входит в этот процесс. Не буду подробно расписывать по каждому пункту — на эту тему можно целые книги писать. Выделю лишь основные моменты, которые можно условно поделить технические и организационные.

Технические моменты:

- ТО инженерного оборудования и систем;

- ремонт;

- замена/модернизация;

- мониторинг и обходы/осмотр оборудования и систем;

Организационные моменты:

- ведение документации (инструкции, регламенты);

- сбор и анализ статистики по поломкам и ремонтам оборудования;

- закупка, хранение ЗИП и расходных материалов;

- контроль за установкой ИТ-оборудования;

- планирование ТО, назначение нарядов в работу;

- подготовка и обучение персонала.

Закрытые стойки 47 юнитов или больше

Стойка в дата-центре Тушино с разводкой под флаг России

Стойки бывают 42U. Такие были раньше. Последнее время в основном ставят 47U, реже 48U. Один юнит в 19″ равен 44.45 мм (1,75 дюйма) по высоте. Одноюнитовый сервер имеет высоту чуть меньше, чтобы сервера можно было легко вставлять и вынимать из стойки.

Обратите внимание на количество розеток в стойке. Совсем не факт, что их будет 47. . Узнайте мощность выделяемую на стойку

Обычно это 5кВт. Бывает пишут и 10кВт и даже 15кВт. Подать такую мощность вам смогут, но вот не перегреется ли ваша стойка — вопрос открытый. Проблема с отводом тепла может возникнуть

Узнайте мощность выделяемую на стойку. Обычно это 5кВт. Бывает пишут и 10кВт и даже 15кВт. Подать такую мощность вам смогут, но вот не перегреется ли ваша стойка — вопрос открытый. Проблема с отводом тепла может возникнуть.

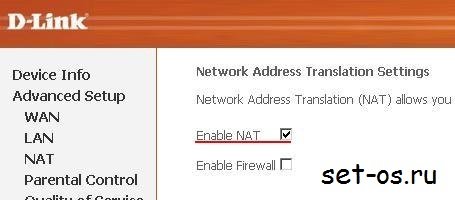

Часто бывает, что к стойке подведены два луча в расчёте, что всё оборудование клиента имеет два блока питания. В этом случае они должны быть подключены к блокам розеток (PDU), включенными в разные лучи. Если у вас есть оборудование с одним блоком питания, то узнайте есть ли АВР (автоматический ввод резерва). Если ЦОД не предоставляет АВР, то вам понадобится приобрести стоечный АВР для подключения такого оборудования.

Узнайте как именно питание и оптика заходят в здание ЦОД и непосредственно в машинный зал.

Стойки бывают открытые. Но так давно уже не модно. Стойки должны ещё и на ключ закрываться. Если охлаждение организовано плохо, то закрытые стойки перегреются.

Администрирование и апгрейды арендованных серверов

Эксперты отмечают, что в классическом сценарии вопрос администрирования программного обеспечения арендованных серверов отдается на откуп компании, которая пользуется их мощностями — клиенту. Для этого арендатору нужно быть уверенным в том, что техперсонал компании-партнера обладает достаточными знаниями в области настройки программного обеспечения и готов оказывать всю возможную поддержку при решении сложных или нестандартных случаев.

| Апгрейд или модернизация арендованных серверов проста и отлажена, — объясняет на примере ГК «Филанко» Дмитрий Шаров. — Так как между клиентом и ЦОД DataHouse.ru уже есть коммерческие отношения, то если в рамках договора клиент запрашивает внесение изменений в какие-либо параметры, например, увеличение оперативной памяти или замену обычного жесткого диска на SSD-диск, ЦОД DataHouse.ru делает это, руководствуясь ранее согласованными ценовыми условиями. |

Наши принципы ценообразования

По ценам у нас были жаркие споры. Мы прорабатывали разные варианты. И чтобы проще было отбирать годные накидали следующие принципы:

-

Отличие от конкурентов. На рынке нужно выделяться из толпы.

-

Прозрачность и простота. Возможность увидеть сразу конечную цену на своё оборудование без скрытых платежей в зависимости от суммарных параметров.

-

Линейность, чтобы двухкратный объём услуг стоил в два раза больше. Снизить цену маломощным и одноюнитовым.

-

Понятное отличие цен в сертифицированном Tier III ЦОД и в несертифицированном.

-

Возможность “настройки” цены для отдельных сегментов оборудования.

-

Формирование “кривой” цены таким образом, чтобы получить максимальную прибыль при минимальной цене в своем сегменте.

Технические причины

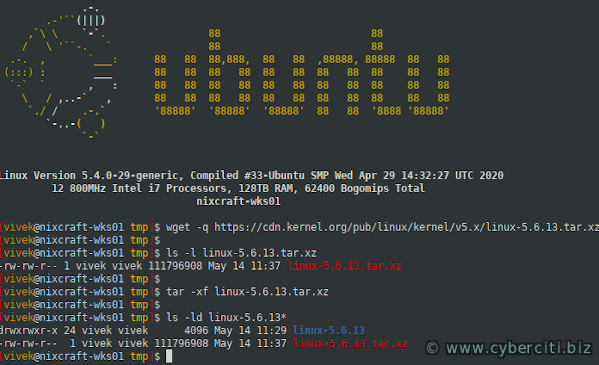

Статическое электричество. Разряд статики может погубить чувствительную электронику, поэтому в дата-центрах особенно внимательны к мерам борьбы со статическим электричеством. Например, в отраслевых стандартах легко найти графики зависимости статического электричества от влажности:

Пример выдержки из стандарта: пособие от ASHRAE.

Именно поэтому в каждом дата-центре необходим постоянный климат. Еще для борьбы со статикой важны используемые материалы, поэтому хорошим тоном считается антистатический фальшпол, антистатическая упаковка и так далее.

Тем не менее мы слышали грустные истории про разряды статики в небольших серверных, где следить за постоянной влажностью сложнее. Можно посоветовать, например, специальные браслеты для снятия статического электричества с тела человека:

Найти нужный вариант легко по запросу «антистатический браслет».

Кабели питания. Иногда заказчики в погоне за экономией используют слишком тонкие некачественные шнуры для подключения оборудования. Такие кабели со временем не выдерживают нагрузку и прогорают.

Чаще всего в стойках используют кабели C13–C14, но у них бывает разное сечение. Шнуры с сечением 0,75 мм2 очень распространены, но в ЦОДе им не место. Мы рекомендуем кабели хотя бы от 1 мм2.

При неаккуратной установке оборудования случается, что кабель питания воткнут не до конца. В результате получаем плохой контакт с меньшей проводимостью и более высоким сопротивлением. А если этот контакт еще и регулярно задевают, то возникает место соединения, которое нагревается больше положенного. Рано или поздно на этом луче сработает вышестоящий автомат (и правильно сделает — ситуация пожароопасная).

В идеальной ситуации могут помочь кабели и разъемы от одного вендора, которые соединяются в прочную пару по принципу «папа-мама»:

В большом коммерческом ЦОДе редко удается использовать решения от одного вендора, но для небольшой серверной рекомендация может подойти.

Для всех остальных бывают специальные силиконовые накладки, которые работают как уплотнитель для кабелей разных типов:

Также стоит быть аккуратными с переходниками на кабель. Например, для кабелей питания иногда используются переходники с С19–С20 на С13–С14

Но что тут важно: разъем С19 рассчитан на 16 А, а разъем С13 — на 10 А. С использованием переходника допустимая сила тока меняется, важно про это не забыть.

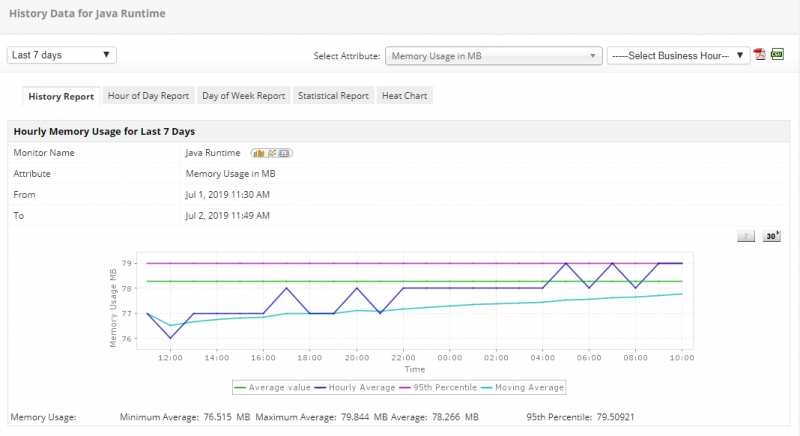

Высокие температуры. Нормальный температурный режим важен не только для серверов, но и для автоматических выключателей. Мы уже рассказывали, как однажды в стойке АВР оказался зажат между серверами со стороны горячего коридора и не охлаждался нормально. Это свело АВР с ума:

Так же пагубно жара влияет на автоматы в щите. С учетом температурной коррекции автомат номиналом 25 А в жару выше 30 градусов легко может превратиться в автомат номиналом 23 А.

Зависимость номинального тока автомата от температуры. Слева в первом столбце ищем нужный номинал и смотрим, как он меняется при разной температуре (сверху).

Другими словами, в жарком помещении автомат выключится раньше. А значит, нужно учитывать место установки щита и следить за климатом в этом месте.

Не до конца изученные случаи. Когда в стойке случаются необъяснимые на первый взгляд сбои, мы можем повесить на нее портативный анализатор и попробовать зафиксировать проблему, если сбой повторится. Но если проблема “плавающая”, то можем так и не дождаться повторного случая.

Чтобы лучше анализировать такие случаи, мы постепенно переходим на постоянные анализаторы качества питания. Оснащаем ими лучи после ИБП во всех новых ЦОДах. Скоро они появятся и в давно построенных дата-центрах. В отличие от переносного анализатора постоянный помогает нам собрать информацию во время происшествия и лучше отследить переходные процессы.

Такие цены позволяют дать наилучшую цену для маломощного оборудования. И для мощного цены тоже умеренные. Да, мы не снимаем сливки с маломощного оборудования, но в нашем понимании линейность цены и есть справедливость, чтобы один не платил за другого — колхозы, как показала история, вымерли.

Самое главное, что прайс-лист стал коротким. Если бы можно было не выделять Mini-ITX и ATX, то он бы был суперкоротким. Собственно, для Tier III дата-центра это всего три параметра для большинства клиентов.

Как выбрать дата-центр для размещения или аренды сервера

Большая часть представленных на рынке дата-центров гарантирует достаточно качественный сервис в размещении серверов при сравнимых ценах. Это понятно: компании, которые имеют негативную историю внедрений, не задерживаются на рынке или уходят в перепрофилирование.

Компании-арендатору в первую очередь важно понять, для чего необходимо оборудование. Важным показателем становится показатель связанности сервера с внешним миром: конечно, железо нужно для запуска на нем определенных веб-ресурсов, что, в свою очередь, дает конечным абонентам (пользователям сервиса) лучшую связанность из офиса или дома

| DataHouse.ru — это часть ГК «Филанко», в состав которой входят и магистральный оператор связи, и оператор последней мили в Москве и Санкт-Петербурге, — говорит Дмитрий Шаров. — Поэтому все клиенты ЦОД DataHouse.ru при размещении своего оборудования получают лучший сервис с точки зрения «одного окна» в размещении оборудования и соединения его с интернетом. |

Компаниям, у которых есть потребность в специфическом аппаратном обеспечении, но нет возможности купить свои серверы, необходимо также договариваться с поставщиками услуг аренды. Как правило, типовые конфигурации, пользующиеся неизменным спросом, настраиваются за несколько суток или даже часов. Нестандартные ресурсы для аренды могут потребовать дополнительной проработки, как на технологическом уровне, так и на юридическом: арендодателю всегда придется по вкусу оперативность заключения договора или внесение предоплаты.

В Европе

Аренда стойки в Европе — это решение для зрелого бизнеса. Если ваша ИТ-инфраструктура требует больших вычислительных мощностей, а клиенты находятся в странах Евросоюза, то вам стоит задуматься об аренде серверных стоек поближе к клиентам. Или наоборот подальше от неожиданностей, подстерегающих вашу корпоративную среду в России. Аренда стойки в Европе подходит для провайдеров хостинга и контента, операторов связи, банков, крупных корпоративных клиентов; для любых высоконагрузочных кластерных проектов.

ЦОДы нашего партнера, компании Host-Telecom, расположены в Чехии. При этом сами здания, а также земля и электрические подстанции не арендованы, а находятся в собственности хостинг-провайдера. Это существенно снижает ваши риски, поскольку исключает вероятность резкого повышения аренды или изменения режима работы дата-центра, а также полного выселения с необходимостью перевозить оборудование в другое место.

Дата-центры в Чехии построены в соответствии с требованиями стандарта TIER III, что подразумевает резервирование по схеме N+1. Наши инженеры, работающие непосредственно на площадке, тщательно следят за тем, чтобы TIER III требования неукоснительно соблюдались. Отдельные элементы инфраструктуры ЦОДов резервируются по схеме N+2 и даже 2N.

Наши клиенты имеют возможность выбора подключения от различных интернет-провайдеров. В дата-центрах имеются два (и более) независимых оптоволоконных ввода в здание, что исключает ситуацию обрывов или отсутствия подключения. ЦОДы имеют прямое резервированное подключение к точкам обмена трафиком в Праге (Чехия) и во Франкфурте (Германия). Это позволяет подключить для клиента прямым стыком любого оператора при необходимости.

Мы принимаем на себя ответственность за работу службы технической поддержки в круглосуточном режиме благодаря тому, что наши сотрудники физически располагаются в помещении партнерских дата-центров и имеют доступ к оборудованию наших клиентов (клиент может арендовать закрытую стойку без доступа инженеров техподдержки).

Своя стойка в европейском дата-центре дает вам возможность построить собственную серверную и сетевую инфраструктуру и обеспечить корпоративные требования по гарантированной безопасности.

Мы тщательно отбираем специалистов службы технической поддержки: у нас работают только специалисты советской и российской инженерной школы, все сотрудники работают в штате компании, мы не предлагаем платить нам за чужие услуги. Мы следим за тем, чтобы квалификация сотрудников поддерживалась на высоком уровне, а знания, умения и навыки не устаревали. Для наших инженеров и системных администраторов русский язык — родной. Также они говорят на английском, чешском и немецком языках и обладают необходимыми компетенциями для решения любой проблемы клиента с сотрудниками европейских площадок и сервис-провайдеров.

Мы рады пригласить вас в Чехию и организовать экскурсию в ЦОДы. В случае выбора нас для размещения оборудования вас ждут приятные бонусы, которые окупят командировку специалистов. Для организации визита, пожалуйста, свяжитесь с представителем отдела продаж.

Безопасность

На территории дата-центра должен быть организован пропускной режим. Доступ в конкретные помещения должен осуществляться с использованием СКУД. Должна быть исключена возможность попадания неавторизованных лиц на территорию или в технические помещения дата-центра. Должна быть смена охраны, составляющая не менее двух человек и проводиться регулярный обход.

Доступ непосредственно в машинный зал должен осуществляться в присутствии инженера.

В случае, если машинный зал дата-центра расположен выше первого этажа должна быть обеспечена возможность использовать лифт и тележки для перемещения оборудования.

В дата-центре должна быть смонтирована система пожарной сигнализации и пожаротушения. Хорошим плюсом будет система раннего обнаружения возгорания.

В дата-центре должна быть система защиты от протечек. Идеальным вариантом в данном случае являются полностью изолированные гермозоны.

В дата-центре должны быть камеры, полностью просматривающие все подходы и проходы к дата-центру и внутри него. Глубина хранения архива должна составлять не менее 90 дней.

По вашему запросу должна быть предоставлена возможность физической защиты стойки, установки на стойку дополнительного замка, СКУД или ограждения (Cage) нескольких стоек.

Что нельзя отдавать подрядчику

Все, что записано в технической части, можно и иногда нужно отдать на аутсорс. В этом случае у вас остается только функция управления и контроля над подрядчиками. Кто это должен делать с вашей стороны, расскажу чуть ниже.

С организационной составляющей сложнее. Почти все из этого списка придется делать самостоятельно. Давайте разберемся, почему так.

Ведение документации. Регламенты и инструкции нужны для того, чтобы у всей команды по эксплуатации было одинаковое представление о процессах и алгоритмах действий (например, о том, как надо тестировать ДГУ). А еще для того, чтобы «священное знание» не пропало вместе с заболевшим или уволившимся инженером Васей. В теории написание документации тоже можно доверить подрядчику, — тем более не каждый инженер серверной сможет или захочет заниматься бумажками. Но правда в том, что лучше вас ваши процессы никто не знает, а отслеживать все изменения и поддерживать актуальность документации, не работая постоянно на объекте, вовсе из разряда «миссия невыполнима». Как вариант, совместно с подрядчиком можно разработать документацию, а следить за ее актуальностью уже самим на месте.

Сбор и анализ статистики. Ситуация примерно такая же, как и в предыдущем пункте, поэтому берем ручку/клавиатуру и методично записываем «историю болезни» каждого кондиционера, ДГУ и дальше по списку оборудования. Раз в квартал, полгода или хотя бы год заглядываем туда, чтобы понять, что и как часто у нас ломается. Информация пригодится при составлении бюджета на эксплуатацию, планировании ЗИП, а также поможет выявить, есть ли оборудование, которому уже не помогут ремонты, и его нужно полностью менять.

Контроль за установкой ИТ-оборудования и управление мощностью. Про это многие забывают, а зря. Айтишник увидел свободный юнит и воткнул оборудование, не посмотрев, хватает ли мощности в данной стойке, холода, и вообще правильно ли установил. А все претензии потом инженеру эксплуатации — за моргнувшее питание (из-за того, что сервер c одним блоком питания подключен без АВР или обоими блоками питания в одно PDU) или тормоза оборудования из-за локального перегрева. Чтобы уменьшить количество проблем по этой части, делайте понятные инструкции, чек-листы для тех, кто занимается установкой оборудования, и периодически проверяйте, как установлено ИТ-оборудование (особенно внимательно если загрузка зала перевалила за 50%). Периодичность проверок будет зависеть от того, как часто в машинном зале появляется новое оборудование.

Планирование работ (ТО и наряды на работу). Совместно с подрядчиком согласовываем график работ, исходя из загрузки персонала (не должно быть работ по всем системам в одну неделю). Также выдаем наряды на работу и согласовываем с подрядчиком форму приема работ (акт, чек-лист и пр.).

Бюджетирование. Лучше делать самостоятельно. В зависимости от того, как заведено у вас — каждый месяц, квартал или сразу на год, операционное или инвестиционное. Про составление бюджета своими силами скоро напишу отдельно. Если отдать подрядчику, угадайте, что будет с бюджетом? Правильно, скорее всего, он вырастет. Произойдет это даже не из корыстного умысла подрядчика, а просто потому что он не будет так печься об экономии, как это делали бы вы.

Даже если как-то умудрились отдать подрядчику все описанное выше, то сидеть, закинув ноги на стол, и просто оплачивать счета не получится: подрядчиков нужно обучать и контролировать.

Учить подрядчиков, в первую очередь, нужно жизни правилам работы в дата-центре и серверной. Кроме, «не пить, не курить и не дебоширить», есть и технические нюансы. Например, от вас подрядчик должен узнать, что при ТО кондиционеров нельзя отключать больше одного за раз, а перед тем, как отключить, нужно проверить, что остальные кондиционеры работают исправно.

Контроль за доступом на объект тоже останется на ваших плечах. Проверять актуальность списков, график доступа на объект (круглосуточный или только в рабочие дни), наличие корочек по электробезопасности и прочих необходимых удостоверений — ваша и только ваша задача.

В общем помните, что за работоспособность серверной или дата-центра отвечаете в конечном итоге вы, а не подрядчик.

SLA, NDA, Uptime

Качество сервиса, соглашение о неразглашении, контакты руководства, способы коммуникации, например, поддержка в Telegram,способы оплаты, пробивка юрлица поставщика.

В Европе поддержка, которая бесплатная, как правило, сильно медленнее, чем в России. В Европе за хорошую поддержку обычно нужно доплачивать. Вот цены на поддержку в Европе. Хочешь реакцию в течение 30 минут — плати 119евро. У нас поддержка в режиме онлайн в Telegram уже доступна всем клиентам. Эх… хорошо бы было по 119 евро дополнительно с каждого клиента… Надо европейцам активнее продавать услуги. В Европе, обычно, любое действие из серии «пришлю диски, можете воткнуть» стоит минимум 50 евро (как и просто поменять диски в дедике на другой), а в России уже включено в стоимость.

Что такое ЦОД

Центр обработки информации (ЦОД, colocation и т.д.) – это специализированный объект, предназначенный для хранения серверного и сетевого оборудования. Дата-центр, как правило, играет роль для обработки и последующего распространения информации, кроме этого, он ориентирован на решение бизнес-задач своих клиентов в области предоставления информационных услуг.

Существование таких центров позволяет отказаться от размещения техники в офисном пространстве. Благодаря этому удается поддерживать бесперебойное питание серверов и их корректную работу 24/7 и все 365 дней в году. Дата-центры обеспечивают постоянное электропитание, необходимые климатические условия и прочное соединение с сетью – то есть все, что требуется для непрерывных бизнес-процессов в IT-компании.

Выводы

Наши цены не охватили размещение GPU и блэйд-серверов, которые рассчитываются по индивидуальным условиям. Сделать универсальную модель ценообразования, которая бы смогла объять необъятное не получается. Однако, сегмент обычных серверов мы покрыли хорошо и данная модель является новой для рынка. Жаль, не пришло это в голову раньше.

При дальнейшем росте потребляемой мощности, будет расти цена за мощность и уменьшаться цена за юнит. Мы даже рассматривали вариант вообще одного параметра — платы за мощность. Но пока юнитами нельзя пренебречь и переход должен быть плавным.